هل "الذكاء الاصطناعي" ذكاء بالفعل؟

2023-12-20 | تاريخ آخر تعديل: 2024-04-22 | مدة القراءة: 9 دقائق

ملهم الإبراهيم

| صفحة النقاشيناقش هذا المقال بشكل علمي حقيقة ما يسمى بـ "الذكاء الاصطناعي".

ماهو الذكاء؟

نشاهد في الصور أعلاه صورة كلب أمام رقعة الشطرنج، وصورة أخرى لطفلة، وأخرى لمسنين يلعبون الشطرنج.

أعتقد أننا متفقون أن الكلب لا يمكن له أن يلعب الشطرنج، فليس بمقدوره فهم قواعدها واللعب وفقًا لتلك القواعد. ولكن هل نقول نتيجة لذلك أن الكلب غبي؟

وبالنسبة للمسنين الذين يلعبون باحترافية نتيجة ممارستهم لتلك اللعبة لسنوات طويلة وحفظهم تقريبًا لجميع الحركات فيها، هل نقول عنهم أنهم أذكياء؟

لو أنك تحفظ حركات معينة تؤدي لهزيمة خصمك في لعبة الشطرنج، فهذا لا يعكس ذكاءك، أليس كذلك؟

أما الطفلة، فلو علمناها قواعد الشطرنج للتو، ولعبنا معها، وأظهرت مقدرتها على التفكير، وإنشاء خطة ذكية في عقلها ثم تنفيذها، فهنا نقول عنها أنها ذكية حقًا، ﻷنها لم يسبق لها أن رأت مثل تلك الخطة من قبل، وقامت هي بابتكارها.

يشبه الحاسوب في الأمثلة أعلاه مثال المسنين، فالحاسوب لديه ذاكرة كبيرة، ويمكنه تخزين كافة حركات وحالات لوحة الشطرنج، أي جميع الحالات على الإطلاق! وكذلك حفظ أفضل حركة يواجه بها الخصم في كل حالة، فهل هذا ذكاء؟

لا يوجد في الواقع تعريف متفق عليه للذكاء، ولكنني أعتقد شخصيًا أن الكائن الذكي يجب أن يتصف بصفات عدة، منها الإدراك والقدرة على الاستنتاج والتخطيط. فهل الآلة تدرك؟ وهل يمكنها أن تخطط وتضع طريقة عملها بمفردها؟

مبالغات البشر

إذا كنت من مواليد التسعينات، وقد عاصرت ظهور الهواتف النقالة الأولى، فلا شك أنك كنت منبهرًا بذلك الاختراع.

هاتف تأخذه معك أينما تريد، وتتحدث مع من تريد وأنت تسير في الشارع! لا شك أيضًا أنك سمعت الكثير من عبارات الدهشة والانبهار ممن حولك، رغم ضعف مزايا تلك الهواتف مقارنةً بهواتف اليوم، والتي يُقال عنها اليوم أنها ذكية.

في كل مرة يخترع الإنسان شيئًا جديدًا، يكون ذلك الاختراع مبهرًا له ولمن حوله، ولا يخلو الأمر من المبالغات و "الشطحات" في عبارات الدعاية والتسويق.

فلقد سمعت ربما عن عبارات مثل "تفوق الذكاء الصناعي على الذكاء البشري"، هذه العبارات التي وُضعت إما من قِبل جهّال، أو أناس يقصدون نشر الجهل والتخاريف.

وسأناقش معكم بعد قليل الأدوات التي يطلقون عليها صفة الذكاء، ومزاياها التي تجعلهم ينسبون صفة الذكاء إليها. ولكن لكي لا نخرج عن سياق فقرة المبالغات هذه، دعونا نكمل بالعودة للوراء، ﻷول حاسوب ميكانيكي، وما تم وصفه به آنذاك.

من الحواسيب الأولى والتي كانت حواسيب ميكانيكية، حاسوب "محرك الفَرق" (difference engine) لمصممه تشالز بابج (Charles Babbage). نشاهد في الصورة التالية نموذجًا لمحرك الفرق معاد بناؤه من قبل متحف العلوم في لندن.

وقد صنع نموذج مبسط منه آنذاك بسبب عدم وجود الإمكانيات الكافية، ذلك النموذج الذي يستطيع إجراء بعض الحسابات على أعداد من 6 خانات فقط.

عندما رأت البارونة "بايرون" ذلك النموذج، وذلك عام 1833، قالت[1]:

"We both went to see the thinking machine (or so it seems) last Monday. It raised several Nos. to the 2nd and 3rd powers, and extracted the root of a Quadratic equation."

"لقد ذهبنا معًا الاثنين الماضي لمشاهدة الآلة التي تفكر (أو التي تبدو كذلك). حيث حَسَبت أعداد بِأُس 2 وأس 3، وكذلك حسبت جذر معادلة تربيعية".

على الرغم من أن برنامج الآلة الحاسبة على هاتفك اليوم أقوى من تلك الآلة بأكملها (بفضل قدرات مكونات هاتفك)، إلا أن "بايرون" ووفقًا لزمنها، وصفت تلك الآلة الحاسبة الميكانيكية ذات القدرات المحدودة بـ "الآلة المفكرة" ونسبت صفة التفكير لها. علمًا أن التفكير بعيد كل البعد عن تلك الآلة أو أي آلة مصنوعة من قبل الإنسان، الآن وإلى آخر الزمان.

[1]: https://en.wikipedia.org/wiki/Difference_engine

الذكاء الصناعي

تعني كلمة "خوارزمية" طريقة حل، فلحل معادلة رياضية بسيطة، ننقل المجاهيل للطرف الأول، وهذه هي الخطوة الأولى، ثم ننقل المعاليم للطرف الثاني، وهي الخطوة الثانية، ثم نحسب المعاليم والمجاهيل معًا، وهي الخطوة الثالثة. تشكل هذه الخطوات طريقة الحل، أي الخوارزمية.

يُقصد بالذكاء الصناعي اليوم مايعرف بتعلم الآلة، على الرغم من أن مصطلح الذكاء الصناعي أشمل من تعلم الآلة. وعندما نتحدث عن "تعلم الآلة" فنحن نتحدث عن خوارزميات، وأول ما شاع منها خوارزمية اكتشاف الرسائل الضارة (spam) في البريد الإلكتروني. يمكن أن نأخذ تلك الخوارزمية بصفتها مثالًا بسيطًا لتعلم الآلة، حيث نحتاج لبيانات (رسائل كثيرة مصنفة يدويًا إما ضارة أو سليمة) وندخلها للآلة لبناء معادلة رياضية تحدد الصفات الرئيسية للرسائل الضارة. ويمكننا بعد بناء تلك المعادلة، إدخال رسائل جديدة للآلة، لتقوم بدورها بتخمين صنف الرسالة، إما ضارة أو لا. وتَعلم من خلال استخدامك للبريد الإلكتروني، أن البرنامج يقوم أحيانًا بوضع رسائل سليمة في مجلد الرسائل الضارة، وهذا ما يُعرف بخطأ موجب (false positive) أي أنه صنفها خطأً على أنها ضارة. وبالتالي يكون دور الآلة هنا هو مجرد التخمين، قد يصيب ذلك التخمين، وقد يُخطئ.

نقول عن "مودل" لتعلم الآلة أنه جيد، إذا تم تدريبه على الكثير من البيانات وبحيث وصلت الدقة فيه إلى 90% أو أكثر، وهذا يعني أن احتمالية الخطأ في تخمينه لا تتجاوز العشرة بالمئة.

لا يوجد "مودل" دقته مئة بالمئة. ولا يمكن أن يوجد. وبالتالي، بعد أن نعلم ذلك جيدًا، هل يمكن أن نعتمد على تخمين الآلة في قضايا حساسة، هي يمكن أن نسأل الآلة: “هل أبتر قدم هذا المريض أم لا" لتعطينا تخمينًا نعتمده في قرار البتر؟

والتخمين ذلك يعتمد بالتأكيد على البيانات التي تم إدخالها مسبقًا للآلة. ففي مثال السيارات ذاتية القيادة، لا يمكن للآلة أن تتوقف في حال وجود عائق لم تتعرف عليه مسبقًا (لم يكن موجودًا في البيانات التي تدربت عليها). فربما دربنا الآلة على عوائق مثل سيارة تقف أمامنا، وكذلك المشاة. ولكن ماذا عن حالات جديدة كليًا على الآلة، لا بد أن النتائج ستكون كارثية في حال اعتمدنا كليًا عليها. فمثلًا، بينما تقود سيارتك رأيت شجرة على يمين الطريق وهي تميل باتجاه اليسار، أي باتجاه الطريق، ومازالت تميل وتميل، من الواضح أنها ستقع على الطريق، لابد لك هنا أن تتوقف مسبقًا قبل أن تصبح تحتها مباشرة وتقع فوق رأسك، ولكن الآلة غالبًا لم تتدرب على مثل تلك الحالة، والآلة لا تدرك ولا تستنتج، وبالتالي لن تخمن أن الشجرة التي على يمين الطريق ستصبح بعد قليل في منتصفه! وإذا اعتمدت بدورك على القيادة الذاتية، فإنا لله وإنا إليه راجعون.

- ولكن يوجد اليوم سيارات ذاتية القيادة

نعم صحيح، بل يوجد أيضًا مترو (قطار الأنفاق) ذاتي القيادة، وهو في الخدمة حاليًا في العديد من المدن، وذلك بسبب وجود سكة واحدة، أي طريق ومسار واحد له، ودون وجود عوائق، وبالتالي نسبة الخطر تكون ضئيلة.

تُظهر الصورة التالية مترو بدون سائق في مدينة اسطنبول

أما بالنسبة للسيارات، حيث لا يوجد سكة للسيارة، وبالتالي يمكن أن تذهب السيارة بجميع الاتجاهات، ويمكن أن يظهر الكثير من العوائق في الطريق، سواء طفل أو طائر أو رصيف أو سيارة أو عربة، إلخ.. فهذا كله يجعل إمكانية الاعتماد عليها دون وجود سائق صعبًا جدًا، ولهذا لم يتم السماح باستخدام سيارات ذاتية القيادة في معظم البلدان، أما بالنسبة للأماكن والحالات التي رأيتُها وسمعت عنها، فهي سيارات كهربائية بسرعات منخفضة جدًا ومناطق مفتوحة ولا يوجد بها الكثير من السكان، وبهذا يتم تقليل نسبة الخطر بشكل كبير، فالسرعة المنخفضة لوحدها كافية لتخفيف نسبة الخطر كثيرًا.

وإذا أردنا أخذ مثال آخر، فتخيل أنك ركبت طائرة للسفر من مدينتك إلى مدينة أخرى، وقد سمعت عبر مكبرات الصوت أن الطائرة هذه ستُقلع بعد قليل وبدون طيار، فهي تطير عبر استخدام خوارزميات الذكاء الصناعي! هل ستكون سعيدًا حينها؟

الطيار التلقائي في الواقع موجود منذ زمن، حتى قبل انتشار خوارزميات تعلم الآلة، ولكن لا يمكن الاعتماد عليه كليًا، وإنما يستخدم بصفة مساعد ثانوي، حيث يتيح للطيار رفع يده قليلًا عن المقود ليتناول القهوة مثلًا، ولكن يبقى الطيار منتبهًا لكل شيء ومستعدًا للتدخل بشكل فوري. حتى أن مهنة مساعد الطيار لم يتم الاستغناء عنها.

أما بالنسبة للمسيّرات الحربية والتي تكون بدون طيار، فهي لا تحوي ركاب، ويتم التحكم بها لا سلكيًا من قبل الإنسان.

بعد أن علمنا أن كل ما تعطيه الآلة في النهاية هو مجرد تخمين، فيجب أن نتيقن أننا لا يمكننا الاعتماد عليها في اتخاذ قراراتنا، ويجب علينا استخدامها بالشكل الصحيح، باعتبارها أدوات مساعدة لا أكثر. وستبقى التقنية كذلك، فمنذ أن تم اختراع الآلة الحاسبة وإلى يومنا هذا، ظلت التقنية تساعدنا وتوفر علينا الوقت في بعض المهام الروتينية ذات الخطوات المحددة والمعروفة، أما اتخاذ القرار، فذلك شيء آخر. سنتعرف على كوارث الاعتماد في اتخاذ القرار على الآلة في فقرة لاحقة.

وأخيرًا..يُستخدم في هذا المجال كلمات غير صحيحة علميًا، مثل مصطلح "الشبكات العصبية" (neural networks) والتي يتم فيها الادعاء أن خوارزميات تعلم الآلة تعمل بشكل مشابه لعمل الشبكات العصبية في الكائنات الحية، وهذا خاطئ علميًا. إذًا يجب أن تعلم أن المصطلحات المستخدمة في هذا المجال من "ذكاء" و"شبكات عصبية" وماشابه، إنما هي مصطلحات دعائية لا علاقة لها بالعلم.

ما هي المهن التي يمكن أن تقوم بها الآلة بدل الإنسان؟

بما أن الآلة تعتمد في عملها على برمجة مسبقة، أو على التخمين، فلا يمكن استخدامها في أمور حساسة، مثل المجالات الطبية والعسكرية، وأي مجال قد يشكّل خطرًا على حياة الإنسان. (نعم، يُستخدم الذكاء الصناعي اليوم ليساعد الأطباء في تشخيص المرض مثلًا، وليس لاتخاذ القرار أو لكي يحل محل الطبيب)

لقد لاحظت أن الاشخاص الذين يتحدثون عن هذا الموضوع يخلطون بين البرمجة العادية للآلة، وبين موضوع تعلم الآلة الذي انتشر مؤخرًا. لنتعرف على الفرق بينهم عبر الأمثلة.

يمكننا عبر البرمجة العادية استخدام الآلة في مهام روتينية ذات خطوات محدودة تتكرر باستمرار ولا تتضمن مخاطر، فيمكن مثلًا استخدام روبوت لصناعة القهوة، لسببين:

1. تتألف هذه العملية من خطوات محددة ثابتة

2. لا تتضمن هذه العملية أي خطر على حياة الإنسان

فأكبر خطأ يمكن أن تقوم به الآلة هنا هو مقادير خاطئة في البن والسكر، أو أن يُسفح المزيج على الأرض مثلًا، وهذه كلها أخطاء مقبولة.

مثل المهمة المذكورة هذه لا تحتاج لتخمين شيء، فالعملية برمتها معروفة، وخطواتها قليلة وثابتة تتكرر باستمرار مع كل فنجان للقهوة.

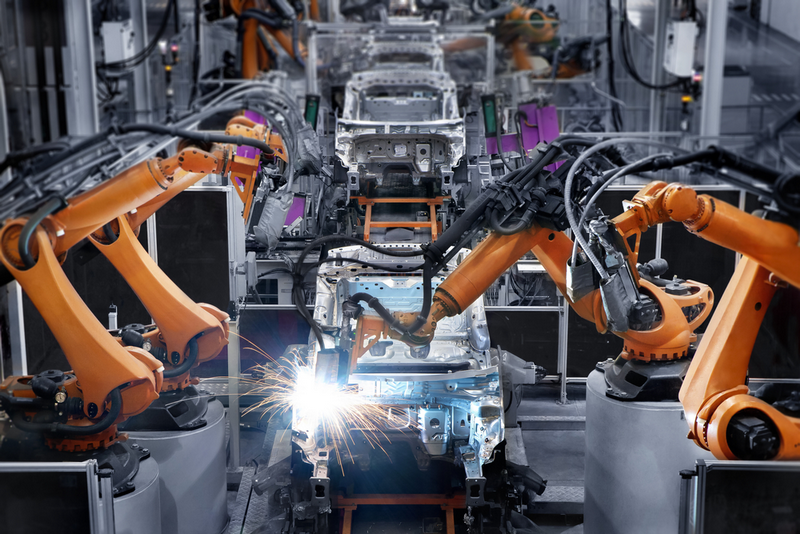

وبالتالي تُتسخدم الآلات في المصانع لتوفير الوقت والجهد واليد العاملة، وذلك في الحالات التي يتحقق فيها البندين المذكورين أعلاه.

تُظهر الصورة التالية أحد مراحل صناعة السيارات والتي تتم كليًا بواسطة الآلة.

أما بالنسبة لتعلم الآلة، فيتم استخدامه عند جهلنا بالخطوات، ففي المثال المذكور سابقًا عن تحديد الرسائل الضارة للبريد الإلكتروني، لا يوجد لدينا مميزات رئيسية ثابتة للرسائل الضارة، وبهذا يمكن استخدام تعلم الآلة، بشرط وجود بيانات كثيرة (رسائل كثيرة مصنفة مسبقًا) وموارد كافية (للحساب وتخزين البيانات)، وهذان الأمران هو ما يحتاجه أي مشروع أو تطبيق لتعلم الآلة.

وبهذا نجد أن المهن التي يتم استخدام تعلم الآلة بها، والتي يمكن أن تحل الآلة بها محل الإنسان، هي مهن أيضًا روتينية، مثل مهنة إدخال البيانات، وخدمة العملاء، وما إلى ذلك، علمًا أن هذه المهن أيضًا لا يمكن الاعتماد فيها على الآلة تمامًا، فمثلًا، إذا كان لدينا جدولًا على ورقة مطبوعة ونريد إدخاله للحاسوب، فيمكن اليوم أن نقوم بتصويره، ويتم التعرف على الكتابة وإدخالها بواسطة خوارزميات تعلم الآلة، وهذا شيئًا مفيدًا فعلًا ويوفر علينا الكثير من الوقت، ولكن لا بد من تدقيق الجدول الناتج من هذه الخوارزميات مرة أخرى وتصويب الأخطاء التي نراها.

إن الاعتماد على الآلة في اتخاذ القرار من قبل تعلم الآلة والتعلم من الأخطاء أو ما يعرف بـ reinforcment learning إنما يستخدم في الألعاب فقط.

وماذا عن ChatGPT؟

يُعتبر هذا التطبيق اليوم من أبرز الأمثلة على تطبيقات تعلم الآلة، والذي يستخدم خوارزميات مخصصة لمعالجة لغات الإنسان، أو ما يُعرف بـ Natural Language Processing واختصارًا NLP. ويبقى كما تطبيقات تعلم الآلة، يحتاج للعنصرين الرئيسيين؛ البيانات الكثيرة والموارد العالية. فمع انتشار النصوص الكثيرة على الإنترنت وبشكل ضخم جدًا، أصبح بالإمكان عمل مودل لتعلم الآلة يتم تدريبه على تلك النصوص لتوليد نصوصًا جديدة، وبعبارة أوضح، لتخمين الكلمة اللاحقة لأي جملة.

لم يتم تدريب مودل ChatGPT على النصوص المتاحة للعامة فقط، بل على نصوص وكتب مدفوعة وغير متاحة للعامة، وفي ذلك خرق لحقوق التأليف والنشر، ولكنه لا يتضح تمامًا بسبب استبدال المودل لمرادفات الكلمات بدلًا من استخدامها كما هي، وبالتالي يصعب تحديد المصدر الذي تم استخدامه عند توليد نص ما، وهذه سلبية أخرى، حيث لا يمكن استخدام شات جي بي تي على أنه مرجعًا علميًا بسبب عدم معرفة المصدر الذي أخذ منه تلك المعلومات، وبالتالي يمكن أن تكون خاطئة، كما أن استبدال مرادفة مكان الأخرى يسبب مشكلة في النصوص العلمية التي يتغير معناها بشكل كبير بحسب الكلمات المستخدمة.

كوارث الاعتماد على الآلة

لقد أظهر فيلمًا وثائقيًا نشرته قناة DW على اليوتيوب، مساوئ الاعتماد على الآلة بشكل كامل في اتخاذ القرار. ففي هولندا مثلًا، قامت وزارة الداخلية باستخدام خوارزميات تعلم الآلة لتحديد المواطنين المشتبه بهم والذي يمكن أن يكونوا "إرهابيين"، وهنا تم تصنيف الكثير من المواطنين على أنهم خطرين أو "إرهابيين"، ودون معرفة السبب تمامًا، وحتى دون أن تعرف وزارة الداخلية المعايير التي تتخذها تلك الخوارزميات في تخميناتها تلك، وقد بدا لهم لاحقًا، أن أحد الحالات كان المواطن فيها مصنفًا على أنه خطر وقد كان ذلك الشخص يحمل جنسية أخرى، فقامت الخوارزمية بتصنيف كل شخص يحمل جنسية أخرى غير الجنسية الهولندية على أنه خطر!

وهناك حالات أخرى لحوادث كثيرة مأساوية نتجت من الاعتماد على خوارزميات تعلم الآلة بشكل أعمى، وهذا هو الاسخدام الخاطئ للآلة عمومًا، فالآلة وُجدت لتساعد الإنسان، لا لتحل محله أو تتخذ القرار عنه.

هل أنت من المؤلفين؟

يمكنك البدء مباشرة بكتابة مقال فور إنشاء حسابك. كما يمكنك التقدم بطلب لإنشاء ونشر مسار على المنصة عبر صفحة

اعمل معنا